Découvrez les Small Language Models (SLMs) : vers une Intelligence Artificielle plus légère et plus performante

Les progrès rapides dans le domaine de l’intelligence artificielle ont donné naissance à des modèles de langage de plus en plus complexes, capables de traiter des quantités massives de données et de réaliser des tâches variées avec une précision accrue.

Cependant, ces grands modèles linguistiques, bien qu’efficaces, posent des défis en termes de coûts de calcul, de consommation énergétique et de capacité à être déployés sur des infrastructures limitées. C’est dans ce contexte que les “small language models” (SLMs) émergent comme une alternative prometteuse.

En réduisant la taille des modèles tout en maintenant des performances compétitives, ces modèles plus légers offrent une solution adaptée aux environnements où les ressources sont limitées, tout en répondant aux exigences croissantes de flexibilité et d’efficacité. De plus, les SLMs permettent de tirer davantage de valeur à long terme grâce à leur accessibilité et leur polyvalence accrues.

Un bref rappel : comment sont développés les modèles de langage ?

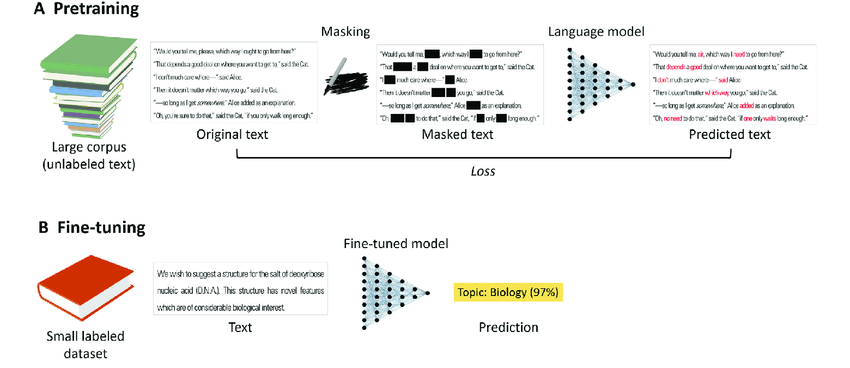

A) Des modèles pré-entraînés

Les modèles de langage sont entraînés sur des tâches auto-supervisées à partir de vastes corpus de texte non étiqueté. Par exemple, dans la tâche de masquage de langage, une fraction des tokens du texte original est masquée de manière aléatoire, et le modèle de langage tente de prédire le texte original.

B) Des modèles fine-tunés

Les modèles de langage (pré-)entraînés sont souvent ajustés sur des tâches spécifiques avec du texte étiqueté, via une approche standard d'apprentissage supervisé. L'ajustement est généralement beaucoup plus rapide et offre de meilleures performances que l'entraînement d'un modèle à partir de zéro, surtout lorsque les données étiquetées sont rares.

Qu'est-ce qu'un Small Language Model (SLM) ?

Un Small Language Model (SLM) est un modèle d’intelligence artificielle (IA) conçu pour traiter le 🔗 langage naturel dans la langue anglaise comme dans d’autres langues, similaire aux grands modèles de langage (LLMs), mais avec une architecture plus petite et optimisée.

Contrairement aux LLMs qui peuvent nécessiter des milliards de paramètres pour fonctionner, les SLMs sont conçus avec moins de paramètres tout en maintenant des performances acceptables pour diverses tâches linguistiques.

Cette réduction de taille permet aux SLMs d’être plus économes en ressources, plus rapides à entraîner et déployer, et mieux adaptés aux environnements où la puissance de calcul et la mémoire sont limitées.

Bien que leur capacité de traitement soit réduite par rapport aux grands modèles, les SLMs restent performants pour des tâches spécifiques, notamment lorsqu’ils sont optimisés avec des 🔗 données annotées de qualité et des techniques avancées d’entraînement. De plus, des outils compacts et performants facilitent l'accès et l'utilisation de ces modèles, rendant leur adoption plus accessible pour les entreprises sans nécessiter une expertise technique approfondie.

Quels sont les avantages des SLMs par rapport aux grands modèles ?

Les Small Language Models (SLMs) présentent plusieurs avantages par rapport aux grands modèles de langage (LLMs), en particulier dans des contextes où les ressources sont limitées ou la rapidité est essentielle. Voici les principaux avantages des SLMs :

Moins gourmands en ressources

Les SLMs nécessitent moins de puissance de calcul, de mémoire et d’espace de stockage, ce qui les rend plus faciles à déployer sur des appareils avec des ressources limitées tels que les smartphones ou les systèmes embarqués.

De plus, les petits modèles de langage montrent une efficacité notable dans les scénarios d'apprentissage 🔗 zero-shot, obtenant des résultats comparables, voire meilleurs, dans certaines tâches de classification de texte.

Coût d'entraînement réduit

Grâce à leur taille plus modeste, les SLMs peuvent être entraînés plus rapidement et à moindre coût, réduisant ainsi les dépenses en énergie et en infrastructure informatique.

Vitesse de traitement

Une architecture plus légère permet aux SLMs d'effectuer des tâches plus rapidement, ce qui est essentiel pour les applications demandant une réponse en temps réel (par exemple : un chatbot).

Déploiement flexible

Les SLMs sont mieux adaptés à des environnements diversifiés, y compris les plateformes mobiles et les systèmes embarqués, là où les grands modèles ne sont pas viables en raison de leurs besoins importants en ressources.

Durabilité

L'entraînement des grands modèles linguistiques est associé à une forte consommation d'énergie et une empreinte carbone importante. Les SLMs, avec leur besoin réduit en ressources, contribuent à des solutions plus écologiques.

Optimisation sur des tâches spécifiques

Bien que plus petits, les SLMs peuvent être extrêmement performants pour des tâches spécifiques ou des domaines spécialisés, grâce à des techniques de fine-tuning permises grâce à des datasets de qualité assemblés grâce à des processus d'🔗 annotation de données de qualité.

De plus, les performances des petits modèles de langage pour la classification de textes sans exemples montrent qu'ils peuvent rivaliser voire surpasser les grands modèles dans certaines tâches.

Quel rôle joue l'annotation de données dans l'efficacité des Small Language Models ?

L’annotation de données joue un rôle essentiel dans l’efficacité des Small Language Models (SLMs). Comme les SLMs ont une architecture plus réduite par rapport aux grands modèles, ils dépendent fortement de la qualité des données sur lesquelles ils sont entraînés pour compenser leur taille limitée. Une annotation précise et bien structurée permet aux SLMs d’apprendre de manière plus efficace et d’améliorer leurs performances sur des tâches spécifiques, à l’exemple des tâches de classification.

L’annotation de données aide également à mieux cibler l’apprentissage sur des domaines ou des applications particuliers, permettant ainsi aux SLMs de se spécialiser et d’exceller dans des contextes spécifiques. Cela réduit la nécessité de traiter de vastes quantités de données brutes, et permet de maximiser les capacités des modèles avec des données annotées de haute qualité. En somme, l’annotation de données optimise l’entraînement des SLMs, en permettant de construire des datasets d'entraînement de très haute qualité pour atteindre une précision et une performance accrues malgré leur taille réduite.

Défis et limites des Small Language Models

Les Small Language Models (SLMs), bien qu’innovants et prometteurs, ne sont pas exempts de défis et de limites. Comprendre ces aspects est déterminant pour évaluer leur utilisation et leur impact dans divers contextes. On vous en dit plus dans un prochain article !

Perspectives futures des Small Language Models

Les Small Language Models (SLMs) ouvrent la voie à de nombreuses innovations et applications futures. Leur potentiel d’évolution et d’intégration dans divers domaines est immense, offrant des perspectives prometteuses pour l’intelligence artificielle.

Conclusion

Les Small Language Models (SLMs) représentent une avancée majeure dans l’évolution de l’intelligence artificielle, en offrant des solutions plus légères, rapides et accessibles, tout en maintenant des performances compétitives. Grâce à leur flexibilité et à leurs besoins réduits en ressources, les SLMs ouvrent de nouvelles perspectives pour des applications variées, des environnements à ressources limitées aux industries soucieuses de durabilité. Alors que les technologies évoluent, ces modèles promettent de jouer un rôle central dans l’avenir de l’IA.

-hand-innv.png)